2023年6月,在杭州举行的2023全球人工智能技术大会上,联想集团CTO、高级副总裁芮勇博士,从产业视角分享了 AI 大模型的发展趋势。7月31日,该分享的主要内容发表在了《中国人工智能学会通讯》2023年第13卷第7期上。以下是内容全文。

0 引言

AI时代,大模型开启了全新科技变革。

我们首先回顾一下信息时代的三个发展历程。

第一阶段是个人计算时代。1981 年 IBM 推出世界上第一台 PC,90年代微软推出 Windows,使 PC 得以走入千家万户。

第二阶段是网络互联时代。1994 年以前互联网已经存在,但是大家只用 FTP、Gopher 传输一些文件,直到网景推出第一款商业浏览器,我们才真正进入了互联网时代。2007 年苹果发布了第一代 iPhone,移动互联网开始腾飞。可以说,没有网景浏览器,就没有今天互联网的普及;没有 iPhone 的出现,就没有智能手机的真正起飞。

第三阶段是AI时代。AI经过了三次起伏,直到 2010 年前后深度学习出现AI才开始加速发展。而 2022 年年底 ChatGPT 的推出,如同早年网景浏览器横空出世,有可能使AI真正进入百姓家。

从上述信息时代发展历程可见,每个阶段都有技术的更新迭代,新技术的出现使社会得到发展的同时,人类的某些技能也显得不再重要。例如,20世纪70 年代末很著名的史丰收速算法,因为个人计算机的普及而消失;1989 年有位全国劳模凭着5种不同记忆法,记下1.2万多个电话号码,100万次电话号码查询没有出错,但是互联网时代的到来使这种技能不再引人瞩目;而AI时代,尤其是 ChatGPT 的出现,使我们对其倍感“惊艳”的同时,对人类社会的发展无比担忧——哪些职业技能将被机器取代,人类还要发展什么技能,这里有很多值得大家思考的问题。

从 ChatGPT 推出到现在将近8个月的时间里,AI大模型技术日新月异,其产品和服务竞相发布。ChatGPT 插件平台能连接到第三方应用程序,如果说ChatGPT 是 iPhone 时刻,那么插件商店就是 App Store 时刻。谷歌推出 Duet AI for Google Workspace,在 Docs 和 Gmail 中辅助写作,在 Slides 和 Meet 中以文生图,在 Sheet 中自定义计划。Windows Copilot 作为AI助手,将集成到 Windows 11 各种应用和程序,包括 Office、Edge 浏览器和 Bing 搜索等。Midjourney V5 对比 V4 有更高的图像质量、更多样化的输出、更广泛的风格范围,尤其在手指的处理上有了明显的真实感提升。OpenAI GPT-4 比 GPT-3.5 生成可靠响应提高 40%,且 GPT-4 是多模态,支持文本和图像输入功能。除了上述闭源大模型外,Meta 公司不甘落后另辟蹊径,将模型 LLaMA 开源,提供非商业许可,其衍生品 Alpaca、Vicuna 等中小模型,训练成本仅几百美元,性能追赶 GPT-4。

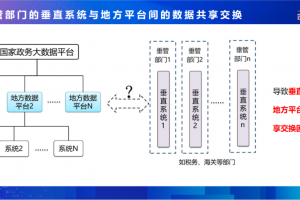

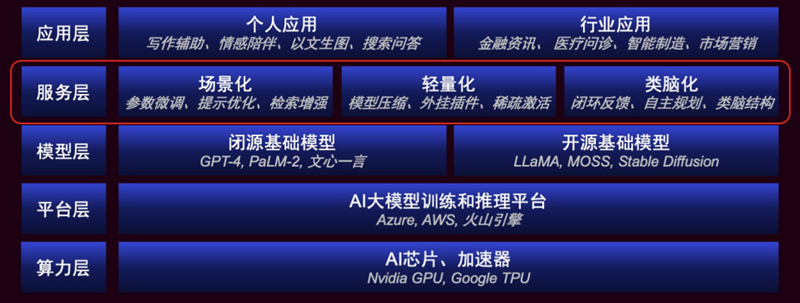

图 1 AI大模型生态的层次结构

图1展示了AI大模型生态的层次结构,从下到上分别是算力层、平台层、模型层、服务层和应用层。这里我们从产业视角看大模型的技术发展趋势,重点关注服务层,它连接下层的“基础模型”与上层的“各类应用”,需要解决大模型在应用落地时的痛点与需求,包括:

• 领域适配和个性化时的“场景化”需求;

• 训练与推理时的计算“轻量化”需求;

• 面对自主规划类问题的“类脑化”需求。

1 大模型的场景化

大模型应用落地,首先要做到场景化。目前大模型基本上都是通用的,今后大模型真正爆发需要一个合理的商业模式,而它一定是垂直行业大模型,根据业务属性提供场景化服务。

我们先看企业用户的需求。

以商品推荐为例,大模型不仅需要在选品时帮助购买者聚焦,而且需要理解购买者的隐含需求。联想开发了一款面向联想商城的大模型,你让它推荐一台笔记本电脑,它会按使用场景分类推荐产品,同时它知道 6.18 临近,还会告诉你相关的打折促销信息。与之对比,如果我们使用一款通用大模型,只能得到同质化的产品推荐和笼统的价格范围,也不会和专用大模型一样提供打折信息。我们再看个人应用大模型所需要的定制化和个性化服务。以 Character.AI为例,它提供深度个性化的AI聊天机器人。虚拟 Elon Musk使用他的公开演讲、Twitter 等数据做训练,模型学习了其中的思想和交流方式,用户在聊天中可以获得很多的启发,如创业观点、对商业的思考方式等;虚拟 Psychologist ( 心理学家 ) 由一个临床心理学专业的学生创建,能在聊天时使人感到更多的理解与共情,而不是程序化地给出建议。这些场景化的需求是真实存在的,所以通用大模型的场景化对企业用户和个人用户来说都极为重要。

如何在通用大模型基础之上满足场景化的需求?其中一个基本方法就是在通用大模型上做全量参数的微调,把相关领域的知识灌进去重新微调后,大模型既具有通用大模型的能力,又具有专用大模型的能力。比如 Bloomberg 公司基于开源 Bloom 开发了金融领域的语言模型 BloombergGPT,它使用了私有金融数据 + 公共数据训练出 50 B规模的模型。BloombergGPT 在金融任务上大大超过了通用大模型,而在通用任务上与通用大模型基本持平。再如 Google 基于自己的 PaLM 开发了 Med-PaLM,用于为医学问题提供高质量的答案。在美国医学执照考试 (USMLE) 问题上,第一版超过及格分数;第二版 Med-PaLM 2 的准确率为 85.4%,达到专家水平。

如果仅微调少量参数 ( 或是额外引入少量参数 ),而无需微调预训练模型的所有参数,那就是参数高效的微调方法 (parameter-efficient fine-tuning ,PEFT),可以降低对计算和存储资源的需求。LoRA (low-rank adaptation of large language models) 是一种 PEFT 技术,它固定预训练权重,引入可训练的低秩分解矩阵并调整其参数。这里可调整的参数量可能只是之前大模型的 0.1% 或者是 0.01%。由于预训练权重不需更新,仅更新低秩矩阵部分的参数,从而减少训练时的计算与存储;并且训练好的低秩矩阵可以合并到预训练权重中,不会引入推理延时。

如果大模型参数固定,调整的是输入问题,就是提示词微调。通过完善提示词的方法,可以挖掘模型的特定领域潜力。

然而提示词微调并不能增加大模型的领域知识,如果我们不去微调大模型,还想挖掘出它的领域知识,则可以采用检索知识库来辅助。将用户查询和本地知识库检索结果一并发送给大模型作为提示输入,可以帮助大模型增强行业知识问答能力。

此外,我们还可以通过外挂插件的办法增强大模型的专业领域能力。比如 ChatGPT 本身对数学的理解并不好,经常会给出错误答案。如果 ChatGPT 外挂 Wolfram Alpha 这个基于符号运算的科学搜索引擎,其理解用户问题可以转化成 Wolfram Alpha 需要的语法;即大模型实现自然语言到外挂模块调用的语法转换,利用它的强大符号运算能力,不仅能给出正确答案,还可以把结果图画出来。但是,Wolfram Alpha 的多轮对话能力非常差,有些问题它完全不懂你在讲什么。我们要想解决类似问题,大语言模型与外挂专有工具相结合会是一个非常好的场景化方法。

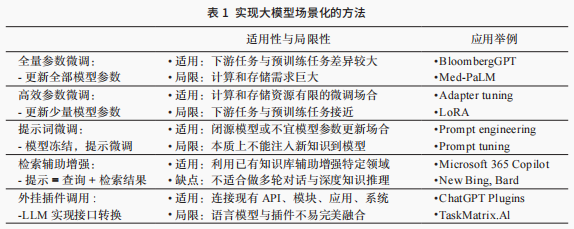

上面提到了五种场景化方法,它们有不同的适用性与局限性。表 1 总结了实现大模型场景化的方法和比较。

2 大模型的轻量化

大模型训练和推理时的能耗惊人。据估算,GPT-3 训练碳排放量约为一名乘客在纽约和旧金山之间往返飞行 550 次;ChatGPT 在 2023 年 1 月期间的推理成本约 1200 万美元左右。大模型的普及需要考虑轻量化,以节约成本和降低能耗。目前业界在考虑云边端协同的方式来部署大模型,这样可以带来低延迟、本地化、个性化等好处,同时也保护隐私与数据安全。如果进行边侧和端侧部署,也需要考虑大模型的轻量化。

采用 MoE (Mixture of Experts) 设计的网络可实现稀疏激活,从而实现训练和推理的高效计算,达到轻量化目的。MoE 可简单理解为模块化网络,每个子网络是个 expert,负责一个子集数据的推理任务。MoE 设计可以将 expert 数量加到很大,推理根据任务激活对应专家,从而实现高效计算。这个概念在 1991 年由 Michael Jordan 和 Jeff Hinton 等提出。2017年,Quoc Le、Geoffrey Hinton 和 Jeff Dean 将 MoE 结构嵌入到 RNN,使推理时极少数 expert 会起作用。这种稀疏性使在增加 expert 数量的同时,计算更高效。2021 年,Google Brain 的研究人员开发了 Switch Transformer,它是在 T5 模型的基础上加入了 MoE 设计,得到了一个“又快又好”的预训练大模型。2022 年,Jeff Dean 等基于 MoE 提出下一代 AI 架构 Pathways,单模型实现多任务、多模态,以及高效模型训练;随后发布基于 Pathways 的语言模型,即 PaLM 和 PaLM-2。

如果在设备端部署大模型,可以使用模型压缩和优化技术来达到轻量化。MLC-LLM 实现了在个人设备上本地环境运行大模型,Vicuna-7B 经优化后仅需 4 GB 内存,在 iPhone 14 Pro 和 iPhone 12 Pro 可实时运行。

另外,我们让大模型只维持“基本功能”,外挂模块实现能力扩展,也可以实现大模型的轻量化,比如前面提到的插件功能,还有Toolformer和TaskMatrix.AI 等工具也是类似的思路。就大模型本身的能力而言,目前基于 LLaMA 的一系列中等规模的开源模型能力也在逐渐接近 GPT-4,我们可以从 UC 伯克利大模型排行榜上看出来。

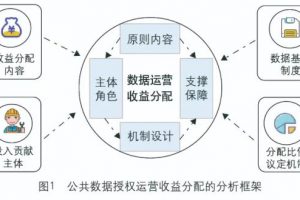

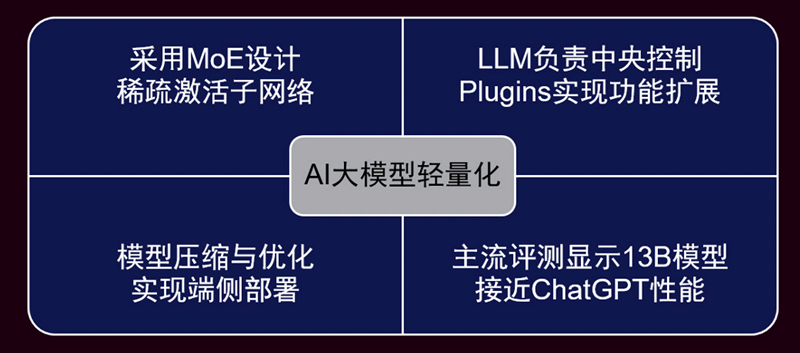

图 2 实现 AI大模型轻量化的驱动技术

图 2 总结了实现大模型轻量化的驱动技术,包括采用 MoE 设计稀疏激活子网络,压缩与优化模型实现端侧部署,大模型负责中央控制、外挂插件实现功能扩展等。另外,主流评测显示最近发展起来的 13B 左右模型正在接近 ChatGPT/GPT-4 性能。

3 大模型的类脑化

虽然今天的 AI大模型非常强大,但是它和人脑机理很不同,还有很多问题并没有很好的解决。想要达到通用人工智能 (AGI),大模型还需要发展闭环反馈、自主规划、类脑结构等技术。

深度学习三巨头之一的 Yoshua Bengio 提出了五个层次的 World Scope(世界规模)概念来反映语言模型的进步。

第一层的世界规模基本上就是文本数据——自然语言训练的语料,模型的认知就是我们给它语料的大小。

第二个层次,从文本数据上升到互联网级别的数据,相当于 GPT-3,它对世界的认知则是对整个互联网的认知。

第三层,不仅是对文本的认知,还是一个多模态的认知,相当于 GPT-4,它对图片有了认知。

第四层是物理世界的交互——AI模型能感知物理世界的环境状态,自主决策后续行动方案。

第五层是多智能体协作——AI模型感知其他智能体的能力与行为,自主决策协作策略。

目前主流大模型仅达到第三层,第四层和第五层也有一些前沿探索。

例如,谷歌对 World Scope 第四层进行了探索,PaLM-E 实现了闭环反馈的机器人规划控制,其解决的问题是如何将四种不同颜色的积木推到棋盘的四个角落,且每个角落积木的颜色相同。任务以文本序列形式输入大模型, 大模型生成机械臂控制指令。摄像头观察棋盘的情况,转化成 token-sequence 反馈到大模型,生成进一步的机械臂控制指令,这个闭环反馈重复直到任务完成。最近流行的 AutoGPT 系列 Agent,可以认为是对 World Scope 第五层进行了探索。这类 Agent 可进行状态记忆和任务调度,基于 GPT-4 做任务理解,与搜索引擎等工具(广义的智能体)协作实现复杂任务。BabyAGI 就是这样的一个任务驱动型自主 Agent。对于提问“作为AI应该如何让世界变得更美好? ”,BabyAGI 先产生一个初始建议列表,然后逐个分析。其中第 3 个建议是“利用AI帮助创造更高效和可持续的能源”,它经过思考认为第一次搜索结果不充分,又改变提问方式,进行第二次搜索后得到满意答案。

微软对 GPT-4 的实验报告《通用人工智能的火花》指出当前大模型的局限,“next-word prediction 机制缺乏任务规划能力”。例如,问大模型 150 ~ 250 中间有多少个质数,它通常给出错误的回答。我们换一个问法,让它先列出 150 ~ 250 之间的质数,再数数有多少个,它就能回答正确了。 这其实是通过思维链辅助大模型做复杂问题的分解与规划。AutoGPT 系列则通过外置记忆模块与任务调度来实现复杂问题的分解与规划。丹尼尔·卡尼曼在《思考,快与慢》指出,快思考是一种直觉思维,容易出现错误和偏见;慢思考是一种理性思维,更准确可靠。现代大模型更类似于快思考,它需要慢思考机制来“规划”问题。学者们已经提出不同的类脑结构来改进当前大模型的不足,例如 Yann LeCun 提出实现自主智能的“世界模型”架构。

最后让我们回忆生成式理念的先驱——理查德·费曼(Richard Feynman,1918—1988)。费曼是加州理工学院物理学教授,因对量子力学的贡献获得了 1965 年的诺贝尔物理学奖。他被认为是爱因斯坦之后最睿智的理论物理学家。费曼的黑板上有这样一句话“What I cannot create, I do not understand”,它的逆否命题即是生成式 AI的理念“What I understand, I can create ”。

(参考文献:略)

附:芮勇2023年2月接受CCCF关于《AI大模型为智能化变革带来的机遇和挑战》访谈

CCCF:最近ChatGPT火爆全网,您对此怎么看待?

芮勇:ChatGPT是OpenAI GPT系列中为对话场景优化的语言模型,属于Foundation Models,即基础模型,这里我们简称为“大模型”。它的特点可以概括为“一大三多”:一大是指参数规模大,大模型是千亿参数级别的超大型人工智能模型;三多是指利用多来源、多模态、多任务的互联网规模海量数据进行训练。这些训练数据大多是未标记的,模型通过无监督的方式进行预训练,然后适配到各种各样的下游任务,例如自动问答、情感分析、信息提取、图像标注、物体识别、指令执行等。

大模型首先在内容理解领域大获成功,例如BERT问世时刷新了11项自然语言理解任务的纪录。最近大模型又在内容生成领域取得了瞩目成就,也就是我们所说的AIGC。ChatGPT就属于AIGC的范畴,因为ChatGPT本质上是个生成式语言模型,根据上下文语境计算下一个最可能出现的单词,进而生成完整的句子。除了文本生成,大模型也可以成功地应用于代码生成,根据问题描述自动生成代码,或是根据上下文修正代码中的错误。不难理解,代码是程序员与计算机交流的语言,语言模型可以从自然语言扩展到编程语言。此外,大模型还能根据自然语言描述,生成相应的图像和视频,甚至是超现实的艺术作品,这使得普通人也能进行创作。这些都是大模型在内容生成领域的进展。

芮勇:我们可以从以下几方面来理解大模型背后的创新性技术。

- 从模型规模方面看,大模型已经具有数千亿参数,这样的规模使得模型能学习到大量的模式与常识,甚至建立一定的推理能力。例如,早期的深度神经网络VGG-16有1.38亿个参数,ResNet-152有6000万个参数;而大模型GPT-3有1750亿参数,Google PaLM有5400亿参数。可见,大模型比早期的深度神经网络大数千倍;

- 从训练数据来看,大模型是用互联网级别的海量数据训练出来,这种规模的数据集包含丰富的模式、知识和常识。例如GPT-3使用了爬取的文本、高质量的网页、维基百科,以及书籍语料库,总数据量约5千亿词元(tokens);

- 从训练方式来看,机器学习典型的方式是采用全监督方式训练,即训练样本需要有标注。而人工数据标注是传统人工智能系统的瓶颈。近几年发展起来的自监督学习方法,可以使模型直接从未标记的样本中学习特征表示,有效地避免了人工标注耗时耗力的问题。另外,针对语言模型而言,ChatGPT采用了RLHF(Reinforcement Learning from Human Feedback)技术,基本思路就是在训练阶段使用强化学习的方法,直接用人的偏好来优化模型的输出结果;

- 从泛化能力来看,对传统人工智能系统来说,AI模型部署后遇到的环境变化是一个巨大的挑战,往往需要一定数量的领域特定样本来微调或更新预训练模型。而大模型无需更新模型参数,即有多任务多领域的适应能力,甚至可以应对训练时没有遇到过的任务类型和问题领域。

芮勇:我们可以回顾GPT的发展历程来理解AI范式的转变。GPT系列论文的题目就指明了它的发展阶段:

- GPT-1,Improving Language Understanding by Generative Pre-training(生成式预训练提升语言理解能力)。它使用预测下一个词的方式训练出基础的语言模型,对语言产生了理解。然后针对分类、蕴含、近义、多选等下游任务,使用特定数据集,更新模型参数,对模型进行调优与适配;

- GPT-2,Language Models are Unsupervised Multitask Learners(语言模型是无监督的多任务学习者)。这个阶段的GPT通过多任务学习,获得了迁移学习的能力,它初步显示了零样本(zero-shot)设定下执行各类任务的能力,而无需进行任何参数或架构修改;

- GPT-3,Language Models are Few-Shot Learner(语言模型是小样本学习者)。GPT显示出强大的in-context learning能力,即用户用少样示例来说明任务(prompt),例如给出几对英语到法语的单词作为示例,再给出一个英语单词,GPT即可理解用户意图是要做翻译,继而给出对应的法语单词;

- ChatGPT(GPT-3.5),Optimizing Language Models for Dialogue(为对话场景优化语言模型)。这时的GPT进化到指令执行(instruction following)能力,即不必给示例,只要使用自然语言给出指令,GPT就可以理解用户意图。比如,直接告诉GPT要把某个英语单词译成法语,GPT即可执行给出结果。

芮勇:关于大模型能走多远,前景到底如何,是否能实现“多任务,多模态,多化身的大一统”,目前还颇有争议。近几年大模型有了突破式进展,很多人持乐观态度。例如,DeepMind研究主任Nando de Freitas的观点是“规模致胜”,认为只要把模型的规模做大,AI领域的很多难题就解决了,游戏就结束了!然而UC Berkeley教授Jitendra Malik表达了反对观点,认为这些大模型是空中楼阁。提出Foundation Models这一术语的论文作者Bommasani也表达了类似的担忧,认为尽管大模型即将广泛部署,但目前我们缺乏对其工作原理、以及“涌现”性质的清晰理解。从Gartner技术成熟度曲线可以看到,大模型目前处于“期望膨胀阶段”(Peak of Inflated Expectations)。人们对它的期望很高,但我们也应该看到,大模型尚未解决的问题还很多。比如谷歌版的ChatGPT,取名Bard,首次公开展示就出现回答结果不准确的问题,导致公司市值一天之内蒸发超1000亿美元。此外,对话机器人生成的句子里包含的信息无法溯源,甚至包含偏向性和冒犯性言论,等等。可见,通往AGI的道路还很漫长。

芮勇:我们先从技术角度来看看大模型取得突破式进展的原因。从GPT的发展历程中,我们可以看到,大模型背后的算法包括元学习(meta-learning)、小样本学习(few-shot learning)、多任务学习(multi-task learning)、强化学习(reinforcement learning)、人机回环(human-in-the-loop)、上下文学习(context learning)等。其实这些算法都是机器学习领域的基础性问题。这些算法近年来的发展,催生了今天大模型的成功,只不过有些算法在大模型里是隐式实现,有些是与传统方式不同的实现。我们关注大模型的成功,更要关注背后这些基础算法的作用。我们可以把这些基础算法和先进理念应用到自己的AI技术和产品开发当中。可以理解为化整为零,即这些基础核心算法单独使用;化零为整,即实现“大一统”的大模型。另外,大模型会逐渐形成生态,非巨头公司可以站在大模型这个肩膀之上,聚焦工具链,开发应用,或是考虑使用大模型更新业务模式、创新产品形态。

芮勇:将一项技术注入产品或赋能业务,需要综合考虑很多因素。当前阶段的大模型还有很多问题没有解决。另外,用户场景产生的需求不同,应用程序的运行环境也各异,大模型并不是普遍适用的。比如,ChatGPT在与网友的问答中称自己的知识库截止到2021年,因此它无法回答时效性问题,或是进行新闻资讯类对话。也就是说,对于需要不断更新知识的业务场景,目前它还不能胜任。这也是ChatGPT嵌入搜索引擎时的一个重要考虑因素。再比如,大模型表现出多领域多任务的泛化能力,但我们对这种预训练模型无需微调的泛化能力还缺乏清晰的认知。对于工业应用,产线上的缺陷检测,对模型可靠性的要求很高,如果“时灵时不灵”,则会造成重大损失。另外,大模型的参数量在数千亿级别,使用时需要设备端与云端实时联接,那么对于网络通讯能力较弱的嵌入式设备,也不适合使用。当运行环境再苛刻一些,比如仅需要运动检测或唤醒词功能的IoT设备,设备功耗在毫瓦的数量级,不能联网,内存和计算资源也相当有限,这就更不适合大模型的应用了。

芮勇:大模型的兴起,为进行智能化变革的企业带来了很多新的机遇。以微软为例,目前已经推出了编程辅助工具Copilot,可在程序员写代码时自动提供建议。微软还引入AI图像生成器DALL-E 2帮助设计者生成图像,只要输入自然语言描述,AI图像生成工具就会自动生成符合描述的图像。必应和Office软件也计划整合ChatGPT,实现对话式搜索和内容生成的新体验。百度已经将大模型用于行业智能解决方案上。为更好地适配不同行业的任务和提升任务精度,百度的文心大模型使用行业特有的知识与数据对模型进行定制,目前已经发布了11个行业大模型,促进大模型的应用落地。联想借鉴大模型背后的基础性算法,将小样本学习应用到基于计算机视觉的产品缺陷检测当中,提升了质检系统对新产品和新产线的快速迁移能力;此外,联想还将强化学习技术和人机协作的理念应用到供应链优化当中,使得供应链在剧烈变化的环境中不断提升韧性。

大模型的开发、训练、部署、推理为云计算业务的进一步发展创造了新的机会,因为大模型所需的海量计算资源只有云侧才能提供。云平台可以为大模型开发者提供全栈的硬件、软件、工具和服务,以便大数据的存储和大模型的训练。训练好的大模型可以部署在云平台上,提供给终端用户调用。此外,大模型带来的社会问题也需要解决,如AIGC带来的一本正经地说瞎话、真假内容泛滥、人类难以鉴别等,解决好这些问题也会有巨大的商业价值和社会价值。

值得注意的是,大模型的变现模式还不是十分清晰。例如,谷歌担忧引入对话式搜索会影响用户点击搜索结果页面的广告,从而直接影响广告收入。新技术冲击旧模式的同时,也可能会带来新的商业机会。正如Open AI首席执行官Sam Altman指出的“数据飞轮”理念,即使用更多数据可以训练出更好的模型,吸引更多用户,从而产生更多用户数据用于训练,形成良性循环。

芮勇:长远来看, AI新范式(large models + in-context learning)与旧范式(small models + fine-tune)很有可能共存,或是相互结合,而不会单个范式一统天下。联想将充分发挥“端-边-云-网-智”新IT架构的优势,来支撑新旧范式的结合与转换。联想提出的新IT架构,既致力于推动自身的智能化变革,也着眼于赋能各行各业的智能化转型。从刚才我们对新旧范式的分析可以看出,AI模型对运行环境需求越来越高,例如云-边-端的高度协同,异构计算与负载均衡、设备之间的互联互通、数据安全与隐私保护、模型本身的伸缩性与扩展性,等等。联想在这些方面都有着深厚的技术积累,新IT架构在AI新范式加速智能化变革的过程中也会继续发挥重要作用。

除了基础架构之外,联想还在考虑AIGC技术在产品和业务里的应用。比如,在智能设备中对跨模态的生成模型进行优化和裁剪,使之能加载到手机或平板上实现个性化内容生成。在智能解决方案方面,我们考虑把AIGC用于新产品营销与新客户触达。目前,大模型还没有与知识有效结合,我们正在研究数据驱动与知识驱动相结合的方法,即Hybrid Learning来改进大模型的不足。另外,在大模型落地过程中,也需要彻底解决对环境变化或是新领域、新任务的自适应问题,即Adaptive Learning,这些都是联想在人工智能方面的探索方向。

芮勇

芮勇

芮勇博士现任联想集团首席技术官、高级副总裁、联想集团最高决策机构(LEC)成员、联想技术委员会副主席,负责联想集团技术战略和研发方向的规划和制定,并领导联想研究院的工作。在加入联想之前, 芮勇博士曾在微软工作18年,任微软亚洲研究院常务副院长。此外,他还是:中国计算机学会(CCF)会士、常务理事、奖励委员会成员,中国人工智能学会会士,ACM/IEEE/IAPR/SPIE Fellow,以及欧洲科学院外籍院士。

芮勇博士拥有丰富的研发经验,作为首席技术官在联想期间带领团队研发的知名产品包括联想LiCO联想智能超算平台, ThinkCloud云计算解决方案, Moli智能客服系统、daystAR增强现实解决方案等。他在微软期间研发的产品包括必应图片、视频搜索,微软小冰,Microsoft Office (RoundTable, OneNote等),微软认知服务Microsoft Cognitive Services (包括人脸、图片识别,视频分析等),以及Microsoft Satori,Microsoft Hololens等。

芮勇博士拥有东南大学学士,清华大学硕士, 美国伊利诺伊大学博士学位,及美国宾州大学沃顿商学院 Microsoft Leadership Training 证书。

【END】