2025年7月4日上午,2025全球数字经济大会数据要素发展论坛在国家会议中心成功举办。中国科学院院士鄂维南出席论坛并围绕“Data-centric AI 的基础设施”发表主旨演讲。

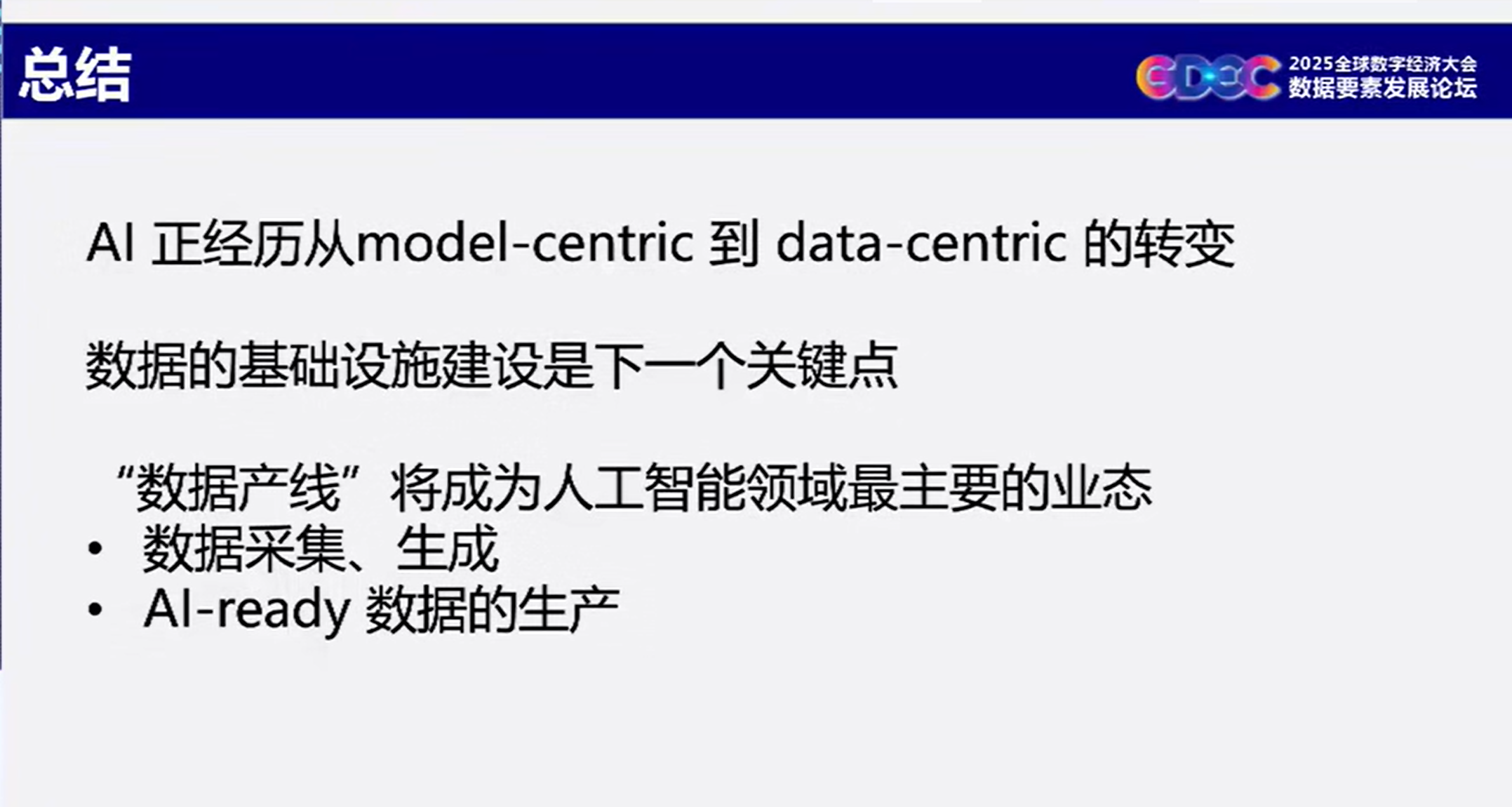

鄂维南院士指出,AI发展正在经历核心转变,从“拼模型”到“拼数据”,从Model-centric AI(MCAI)到Data-centric AI(DCAI)的范式迁移,数据质量与多样性成为突破AI能力的核心引擎。

一、AI发展的核心转变

(一)AI发展的趋势

过去,AI 的成功和进步,依赖模型创新(如ChatGPT基于2017年的Transformer架构)

未来的趋势是,模型创新空间有限,数据质量与多样性成为AI能力突破的核心。

当前主流大模型(如GPT、Qwen、DeepSeek)架构高度同质化,性能差异主要源于数据而非模型本身。

(二)数据是AI的新战场

资源枯竭:高质量公开数据消耗殆尽,私有数据与合成数据成为关键资源;

处理低效:数据清洗、标注、评估高度依赖人工(如GPT-4需数百工程师耗时数月);

企业困境:缺乏专业团队处理保密性强、结构复杂的私有数据。

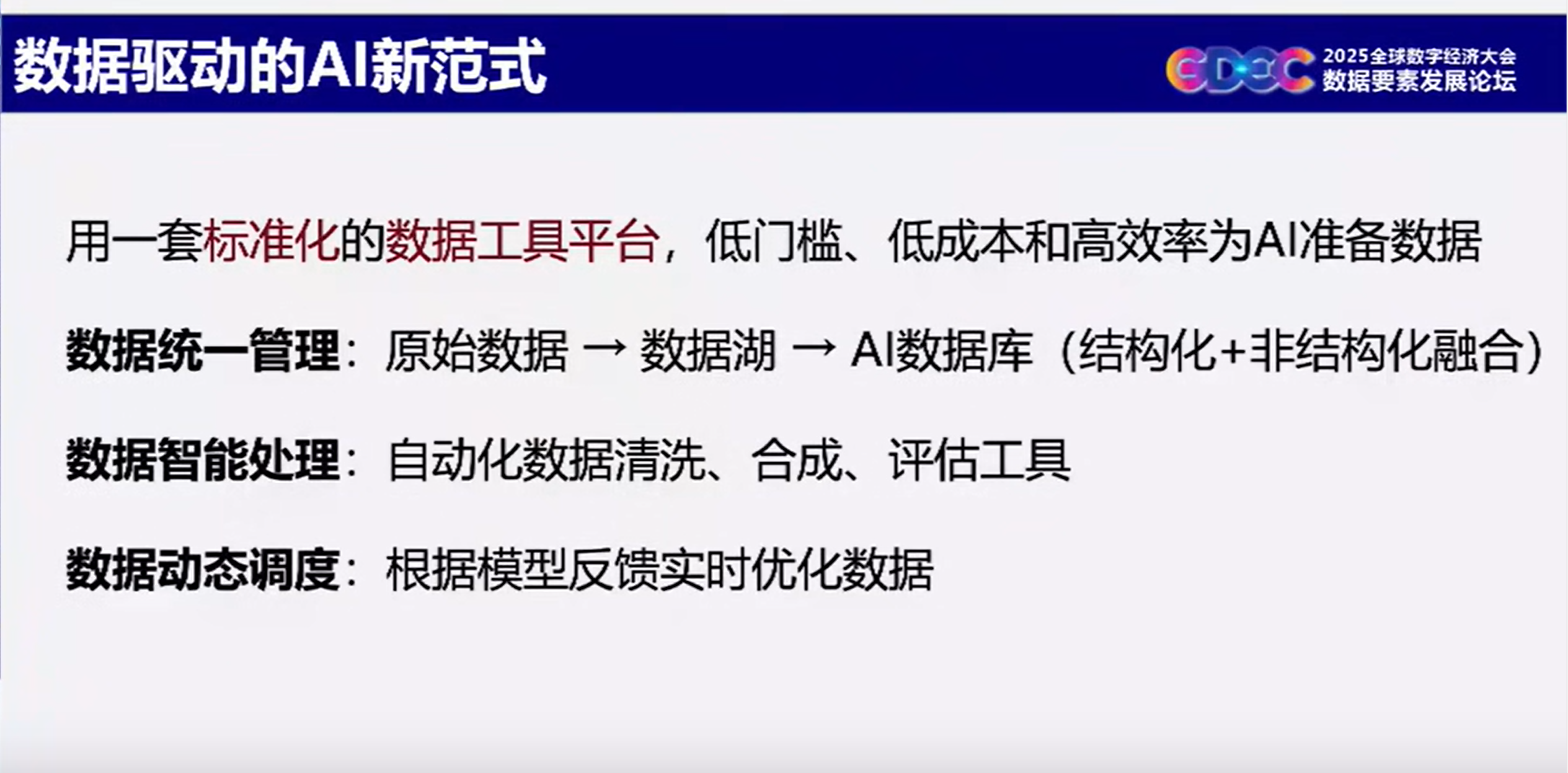

(三)数据驱动的AI新范式

用一套标准化的数据工具平台,低门槛、低成本和高效率为AI准备数据。

用一套标准化的数据工具平台,低门槛、低成本和高效率为AI准备数据。

数据统一管理:原始数据→数据湖→AI数据库(结构化+非结构化融合);

数据智能处理:自动化数据清洗、合成、评估工具;

数据动态调度:根据模型反馈实时优化数据;

(四)模型训练的主要工作量在于数据的准备

传统AI开发中,数据准备占据90%工作量:多模态数据(文本、图像、视频)格式混乱、质量参差、数量不足等问题严重制约模型效果。

Data-centric AI的核心目标是通过标准化工具链,将数据准备转化为自动化、可复用的“数据流水线”。

二、人工智能基础设施

(一)算力和数据

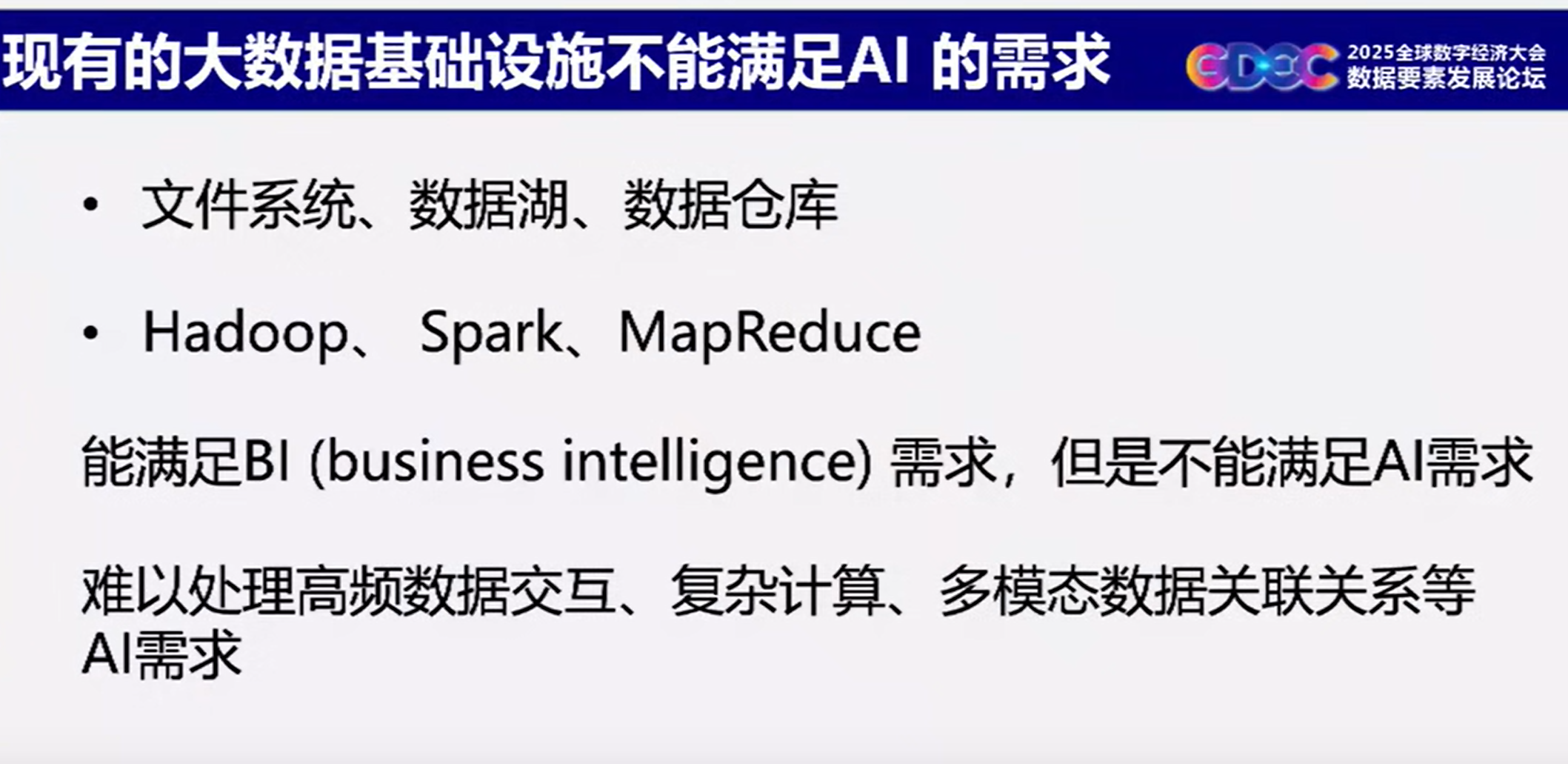

在模型结构基本不变的情况下,大模型开发主要取决于大数据和大算力。

算力基础设施的底层是GPU和相应的工具,如CUDA。在此基础上,TensorFlow等工具建立起了模型和算力之间的桥梁。它们一方面让我们能够快速简便地搭建模型,另一方面也对模型的计算效率作了优化。

在DCAI基础设施里,AI数据库对标GPU作为最底层工具,(拓展了的)SQL+向量生态对标CUDA生态,DataFlow数据准备工具对标TensorFlow等模型搭建工具。在这个思路下,数据湖和数据仓库就像是算力里面的CPU。

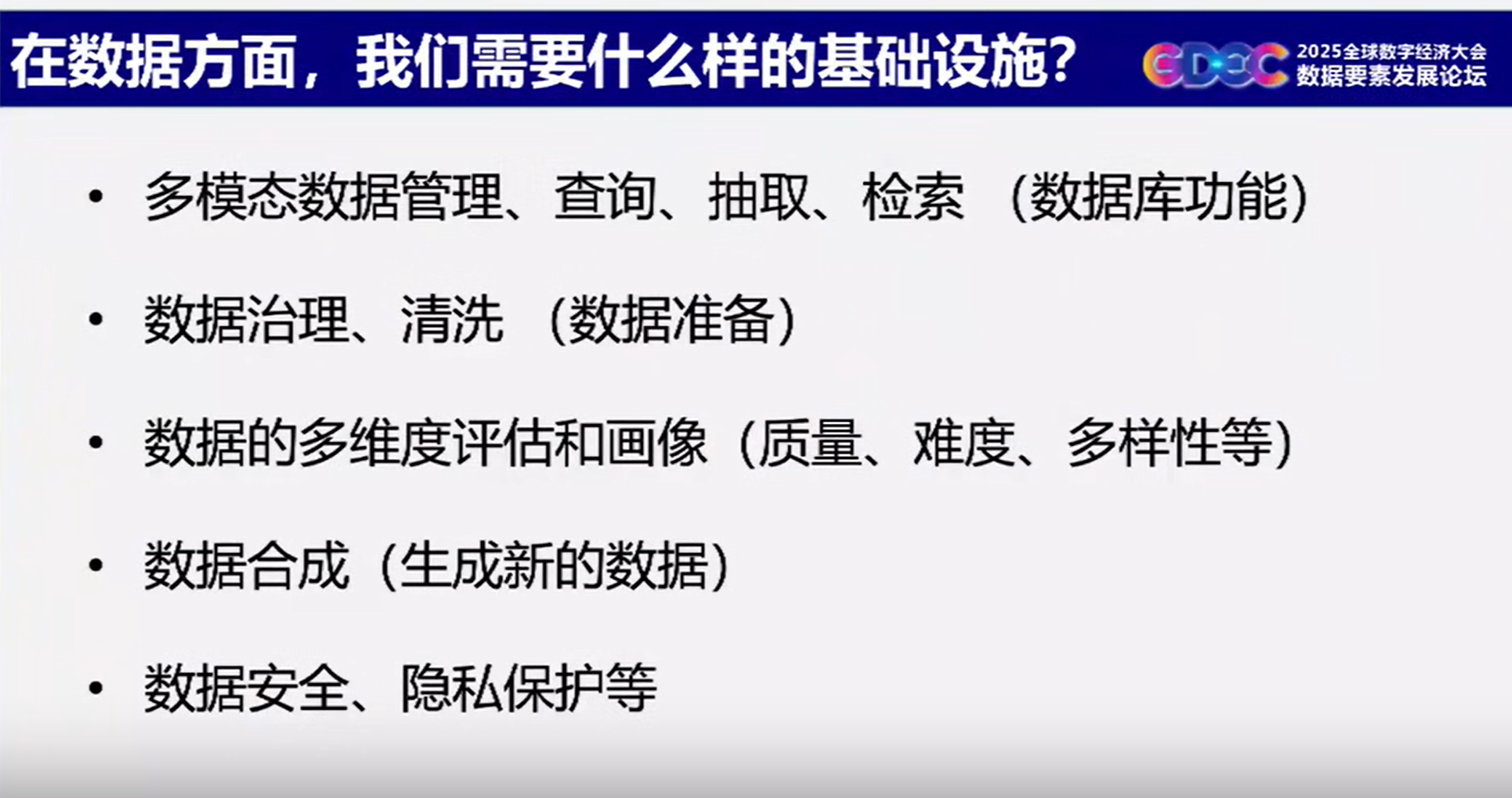

(二)AI数据库

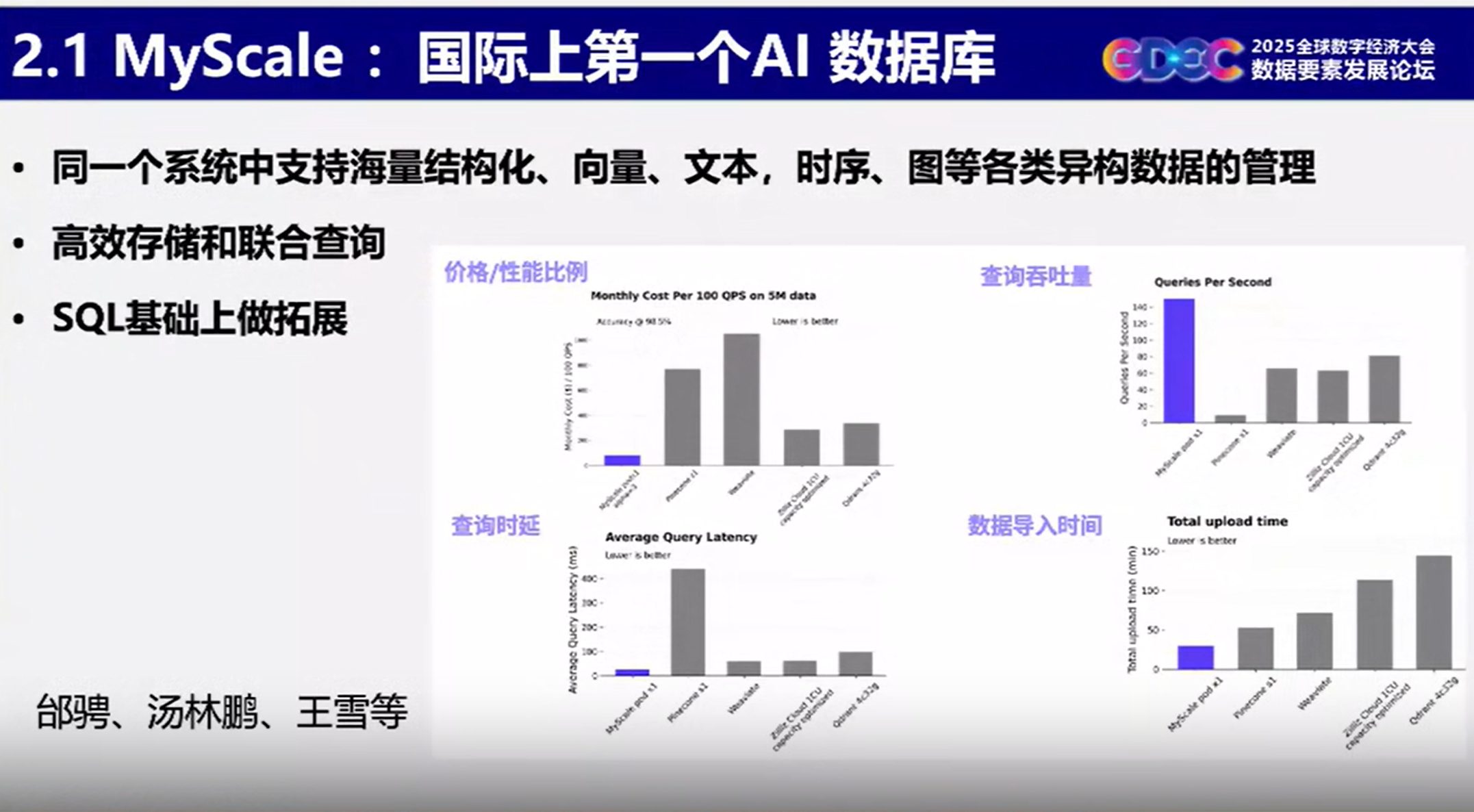

代表产品:MyScale数据库(国际首个AI数据库)

通过扩展SQL,实现结构化数据、向量、文本、时序、图数据的异构融合存储与联合查询。

(三)数据准备工具DataFlow

DataFlow的核心理念是像TensorFlow搭积木编程模型一样编程数据:比如TensorFlow通过组合卷积层和激活层等基础算子得到残差块,再堆叠多个残差块得到经典的ResNet模型。

DataFlow的核心理念是像TensorFlow搭积木编程模型一样编程数据:比如TensorFlow通过组合卷积层和激活层等基础算子得到残差块,再堆叠多个残差块得到经典的ResNet模型。

同样地,DataFlow内置了100+通用处理算子,和20+创新处理算子,结合各个模块的特点以及各种通用和行业算子,针对任务构建算子组合管线。

以强推理数据合成任务为例,该任务需要组合多个模块的算子:数据处理模块算子包括问题预处理、过滤、基于正确性的问题验证算法;数据合成模块算子包括问题合成&扩充、长思维链合成、伪答案生成器;数据质量评估模块算子包括合成问题正确性验证调用、问题难度和类型分类。通过以上算子组合形成的配方最终构成强推理数据合成的管线;

(四)基于AI数据库的下一代LLM训练新范式

数据湖里的原始多模态领域数据结构复杂且质量低,通过DataFlow的数据准备得到包含统计信息的高质量的标准化数据,再通过DataFlex的动态调度来抽取、配比和推荐当前大模型最需要的数据,从而实现大模型的在线训练。

这种方式优点有三:基于AI数据库可以支持高频数据更新和查询特点,可以做到训练数据的实时选择和知识在线更新。其次,整个训练过程几乎无需人工干预,训练门槛低。最后,AI数据库里的知识更容易溯源,模型生成效果更准确安全性也更高。

三、DCAI基础设施赋能

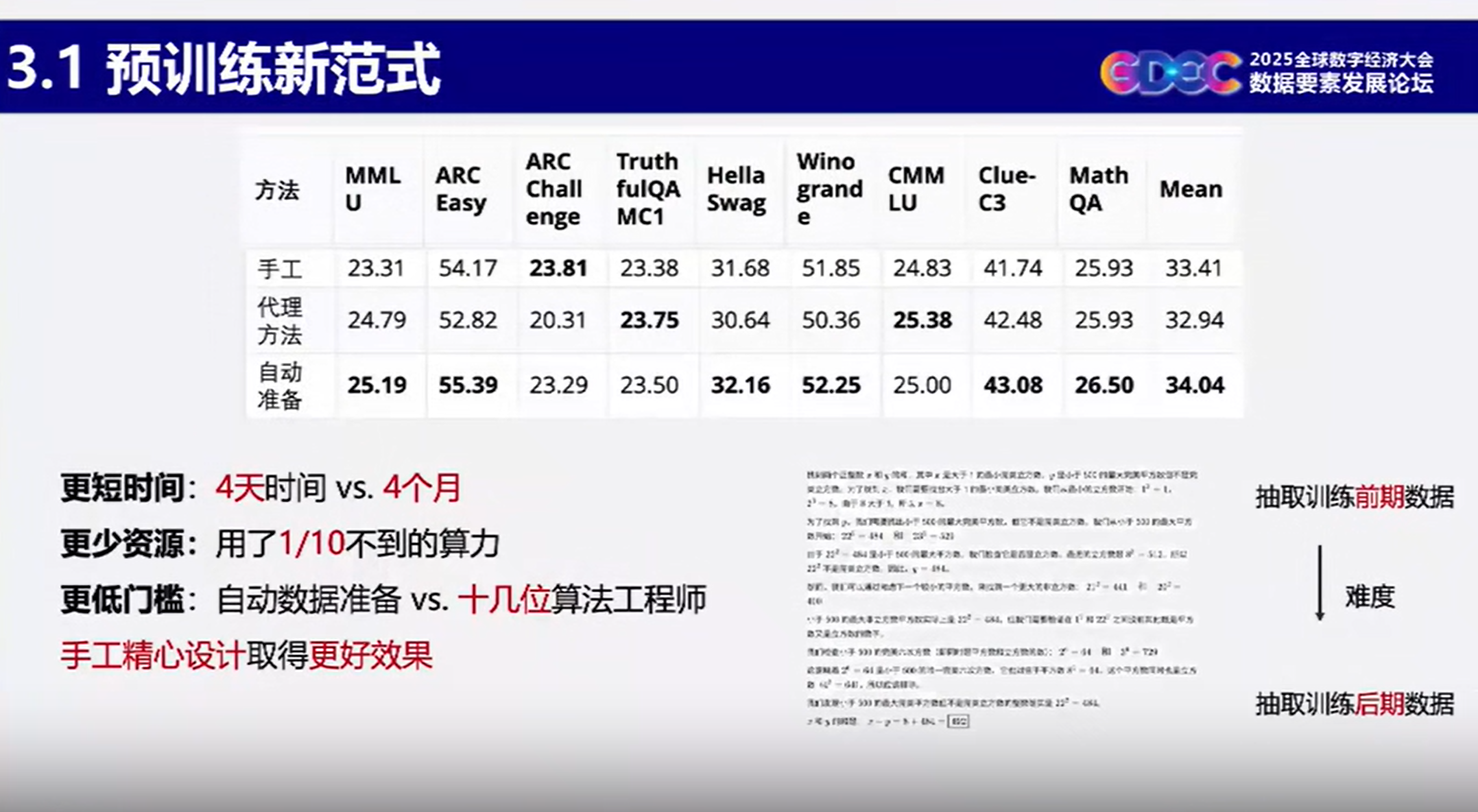

(一)赋能通用大模型预训练效果

更短时间:4天时间 vs4个月

更少资源:用了1/10不到的算力

更低门槛:自动数据准备 vs. 十几位算法工程师手工精心设计取得更好效果

(二)赋能企业私有模型

大模型+自动化微调数据准备

8B RARE 医疗、法律和金融领域模型和 QwQ32B+RAG、GPT-4+RAG 相比,在各项问答指标上均大幅提升。

实现低成本、高性能解决行业任务,深化推动大模型行业落地。

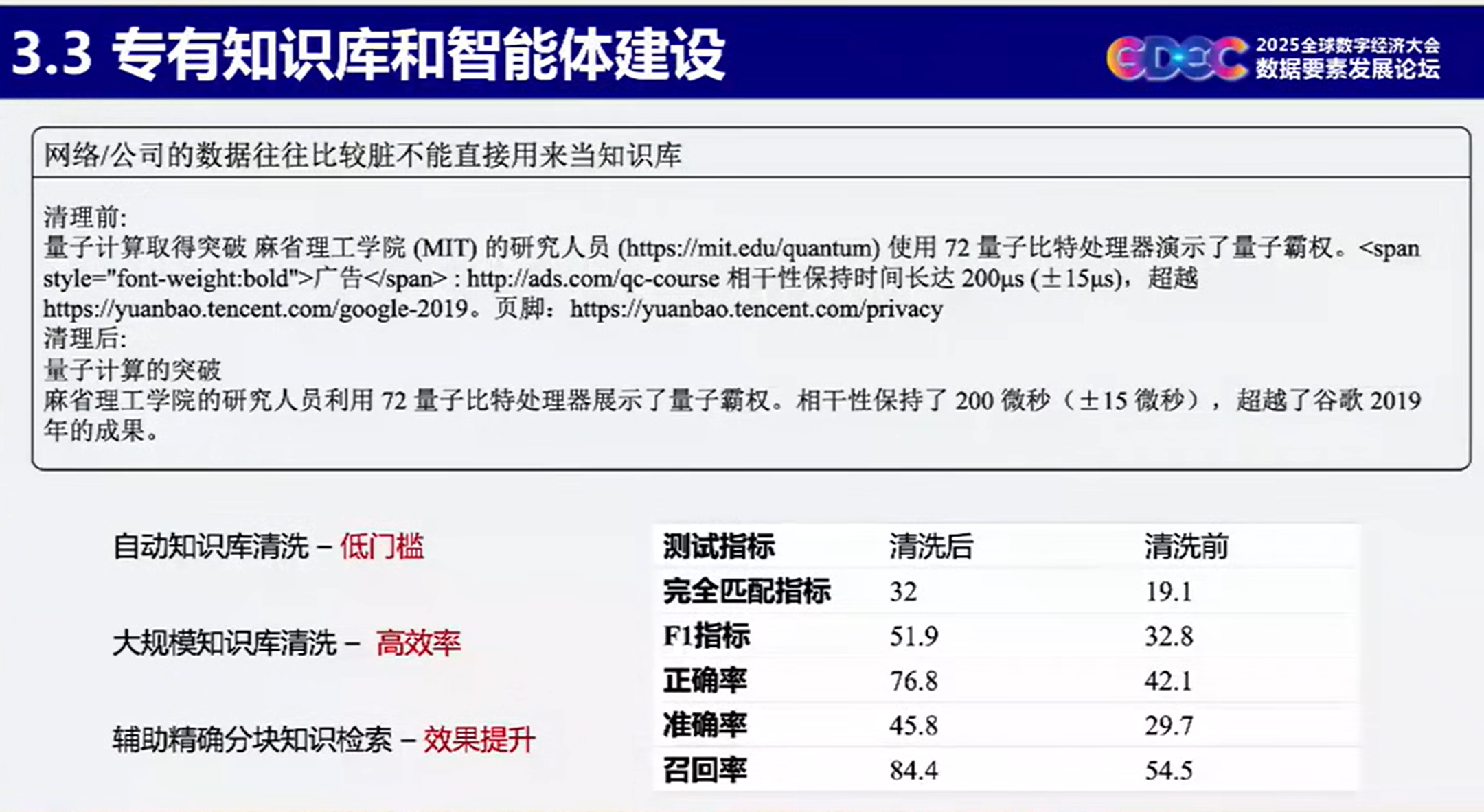

(三)赋能专有知识库和智能体

实现低门槛自动知识库清洗,高效率、大规模知识库清洗、辅助精确分块知识检索效果提升。